1/2ページ

ダウンロード(661.3Kb)

今話題のNVIDIA A100 80Gが8台搭載されたAIシステム!分析から推論までこれ1台!!

DGXシリーズの最新モデル!DGX A100のご紹介です。A100 80Gが8台搭載され、A100から搭載されたMIG機能により、より管理者にとって最高の開発環境を提供いたします。AI開発には欠かせない1台!※A100 40Gモデルは販売終了しております。

関連キーワード

このカタログについて

| ドキュメント名 | NVIDIA DGX A100 |

|---|---|

| ドキュメント種別 | 製品カタログ |

| ファイルサイズ | 661.3Kb |

| 取り扱い企業 | 菱洋エレクトロ株式会社 (この企業の取り扱いカタログ一覧) |

この企業の関連カタログ

このカタログの内容

Page1

NVIDIA DGX A100

AI インフラストラクチャ向けの

ユニバーサル システム

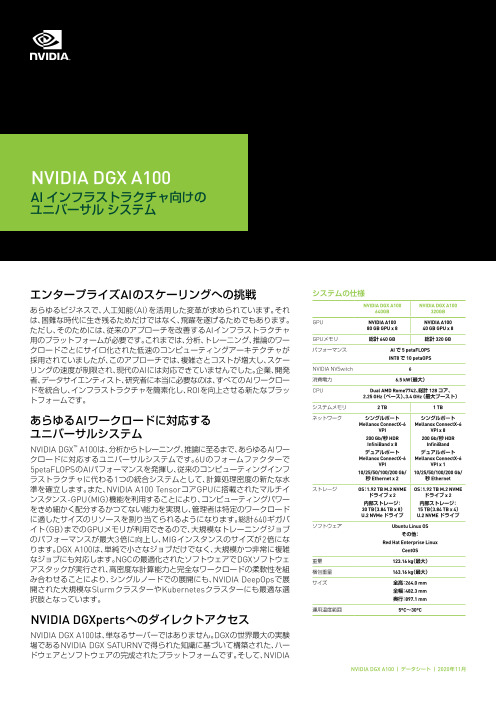

エンタープライズAIのスケーリングへの挑戦 システムの仕様

NVIDIA DGX A100 NVIDIA DGX A100

あらゆるビジネスで、人工知能(AI)を活用した変革が求められています。それ 640GB 320GB

は、困難な時代に生き残るためだけではなく、飛躍を遂げるためでもあります。 GPU NVIDIA A100 NVIDIA A100

ただし、そのためには、従来のアプローチを改善するAIインフラストラクチャ 80 GB GPU x 8 40 GB GPU x 8

用のプラットフォームが必要です。これまでは、分析、トレーニング、推論のワー GPUメモリ 総計 640 GB 総計 320 GB

クロードごとにサイロ化された低速のコンピューティングアーキテクチャが パフォーマンス AI で 5 petaFLOPS

採用されていましたが、このアプローチでは、複雑さとコストが増大し、スケー INT8 で 10 petaOPS

リングの速度が制限され、現代のAIには対応できていませんでした。企業、開発 NVIDIA NVSwitch 6

者、データサイエンティスト、研究者に本当に必要なのは、すべてのAIワークロー 消費電力 6.5 kW(最大)

ドを統合し、インフラストラクチャを簡素化し、ROIを向上させる新たなプラッ CPU Dual AMD Rome7742、総計 128 コア、

トフォームです。 2.25 GHz( ベース)、3.4 GHz( 最大ブースト)

システムメモリ 2 TB 1 TB

あらゆるAIワークロードに対応する ネットワーク シングルポート シングルポート

Mellanox ConnectX-6 Mellanox ConnectX-6

ユニバーサルシステム VPI VPI x 8

200 Gb/秒 HDR 200 Gb/秒 HDR

InfiniBand x 8 InfiniBand

NVIDIA DGX™ A100は、分析からトレーニング、推論に至るまで、あらゆるAIワー デュアルポート デュアルポート

クロードに対応するユニバーサルシステムです。6Uのフォームファクターで Mellanox ConnectX-6 Mellanox ConnectX-6

VPI VPI x 1

5petaFLOPSのAIパフォーマンスを発揮し、従来のコンピューティングインフ 10/25/50/100/200 Gb/ 10/25/50/100/200 Gb/

ラストラクチャに代わる1つの統合システムとして、計算処理密度の新たな水 秒 Ethernet x 2 秒 Ethernet

準を確立します。また、NVIDIA A100 TensorコアGPUに搭載されたマルチイ ストレージ OS:1.92 TB M.2 NVME OS:1.92 TB M.2 NVME

ンスタンス-GPU(MIG)機能を利用することにより、コンピューティングパワー ドライブ x 2 ドライブ x 2

内部ストレージ: 内部ストレージ:

をきめ細かく配分するかつてない能力を実現し、管理者は特定のワークロード 30 TB(3.84 TB x 8) 15 TB(3.84 TB x 4)

に適したサイズのリソースを割り当てられるようになります。総計640ギガバ U.2 NVMe ドライブ U.2 NVME ドライブ

イト(GB)までのGPUメモリが利用できるので、大規模なトレーニングジョブ ソフトウェア Ubuntu Linux OS

その他:

のパフォーマンスが最大3倍に向上し、MIGインスタンスのサイズが2倍にな Red Hat Enterprise Linux

ります。DGX A100は、単純で小さなジョブだけでなく、大規模かつ非常に複雑 CentOS

なジョブにも対応します。NGCの最適化されたソフトウェアでDGXソフトウェ 重量 123.16 kg(最大)

アスタックが実行され、高密度な計算能力と完全なワークロードの柔軟性を組 梱包重量 163.16 kg(最大)

み合わせることにより、シングルノードでの展開にも、NVIDIA DeepOpsで展 サイズ 全高:264.0 mm

開された大規模なSlurmクラスターやKubernetesクラスターにも最適な選 全幅:482.3 mm

択肢となっています。 奥行:897.1 mm

運用温度範囲 5ºC~30ºC

NVIDIA DGXpertsへのダイレクトアクセス

NVIDIA DGX A100は、単なるサーバーではありません。DGXの世界最大の実験

場であるNVIDIA DGX SATURNVで得られた知識に基づいて構築された、ハー

ドウェアとソフトウェアの完成されたプラットフォームです。そして、NVIDIA

NVIDIA DGX A100 | データシート | 2020年11月

Page2

の何千人ものDGXpertsによるサポートを提供しま

す。DGXpertはAIに精通した専門家で、役立つアドバ 大規模モデルでのAIトレーニング性能 AI推論スループットが最大1.25倍

が最大3倍向上 向上

イスや設計に関する専門知識を提供し、AI変革の加

速に向けて支援します。過去10年にわたって蓄積し DLRMトレーニング RNN-T推論:シングルストリーム

てきた豊富なノウハウと経験を活かし、お客様が 3X 2X

3X

DGXへの投資から最大限の価値を引き出せるようお

手伝いします。DGXpertのサポートによって、重要な 2X

アプリケーションを迅速に実行し、スムーズな運用 1.25X

1X

を維持し、インサイトを得るまでの時間を飛躍的に 1X

1X

短縮することができます。 1X

0.7X

最速での解決 0 0

DGX-2 DGX A100 DGX A100 DGX A100 DGX A100

320GB 640GB 320GB 640GB

8基のNVIDIA A100 TensorコアGPUを搭載する FP16 FP16 FP16

1秒あたりのシーケンス数―相対的なパフォーマンス

反復1,000回あたりの時間―相対的なパフォーマンス

NVIDIA DGX A100は、比類のないアクセラレーショ MLPerf 0.7 RNN-T:(1/7) MIG スライスで測定

HugeCTR フレームワークでのDLRM、精度 = FP16 | DGX フレームワーク:TensorRT 7.2、データセット = LibriSpeech、

A100 640 GB(バッチサイズ = 48) x 1 | DGX A100 320 GB(

™ 精度 = FP16

ンを提供し、NVIDIA CUDA-X ソフトウェアとエン バッチサイズ = 32) x 2 | DGX-2(V100 32 GB の16倍()バッ

チサイズ = 32) x 1

ドツーエンドのNVIDIAデータセンターソリューショ GPU の台数に標準化した速度向上率

ンスタックに完全に最適化されています。NVIDIA

A100 GPUは、FP32と同じように動作しながらも1

秒あたりの浮動小数点演算回数(FLOPS)が前世代 ビッグデータ分析ベンチマークでCPUより最大83倍、

の20倍のAIを実現するTensor Float 32(TF32)とい DGX A100 320 GBより2倍性能が向上

う新しい精度に対応しています。最大の特長は、コー 90X

ドを変更することなくこの高速化を実現できる点で 80X

す。またFP16を活用したNVIDIAの自動混合精度機 83X

70X

能を使用すれば、A100ではコードを1行追加するだ 最大 2 倍

60X

けで、さらに2倍の性能が得られます。 50X

最大 83 倍

A100 80GB GPUは、高帯域幅メモリが40GB(HBM) 40X 44X

から80GB(HBM2e)に倍増し、GPUメモリ帯域幅が 30X

A100 40GB GPUを30%上回る、世界初の毎秒2テラ 20X

バイト超を実現しています。DGX A100は第3世代の 10X 1X 11X

NVIDIA® NVLink®を初めて搭載し、GPU間の直接 0

帯域幅を毎秒600ギガバイト(GB/秒)に倍増させて CPUのみ DGX-1 DGX A100 DGX A100

320GB 640GB

います。これは、PCIe Gen 4のほぼ10倍に相当しま 解が得られるまでの時間―相対的なパフォーマンス

す。他にも、前世代の2倍の速度を持つ新しいNVIDIA ビッグ データ分析ベンチマーク | 10 TB データセットで分析リテール クエリ 30 個、ETL、ML、NLP | CPU:Intel Xeon

NVSwitch™も搭載しています。このかつてないパワー Gold 6252 2.10 GHz の 19 倍、Hadoop | DGX-1(V100 32 GB の 8 倍)の 16 倍、RAPIDS/Dask | DGX A100 320

GB の 12 倍および DGX A100 640 GB の 6 倍、RAPIDS/Dask/BlazingSQL GPU の台数に標準化した速度向

によって、最短でソリューションを実現でき、これま 上率

で不可能だったり、現実的ではなかったりした課題

に取り組めるようになります。 構成要素となり、企業は拡張性の高いAIインフラストラクチャの計画を

策定できます。DGX A100は、クラスタリング用に8つのシングルポート

世界で最も安全なエンタープライ NVIDIA Mellanox® ConnectX®-6 VPI HDR InfiniBandアダプターと、

ズ向けAIシステム ストレージとネットワーキング用に最大 2つのデュアルポート

ConnectX-6 VPI Ethernetアダプターを備えており、いずれも毎秒200

NVIDIA DGX A100は、あらゆる主要なハードウェア Gbの性能を発揮します。大規模なGPUアクセラレーテッドコンピューティ

およびソフトウェアコンポーネントを保護する多層 ングと、最先端のネットワーキングハードウェアおよびソフトウェアの

的なアプローチによって、AIを活用する企業におい 最適化を組み合わせることで、数百、数千ノードにまでスケールアップが

て最も堅牢なセキュリティ体制を実現します。ベー 可能になり、対話型AIや大規模な画像分類などの難易度の高い課題に対

スボード管理コントローラー(BMC)、CPUボード、 応できます。

GPUボード、自動暗号化ドライブ、セキュアブート

など、幅広いセキュリティ機能が組み込まれている 信頼できるデータセンターのリーダー企業と共に

ため、IT部門は脅威の評価や軽減に時間を費やすこ 構築された実証済みのインフラストラクチャ

となく、AIの運用に集中できます。 ソリューション

NVIDIA Mellanoxによるデータセ ストレージとネットワーキングの技術を誇るリーディングプロバイダー

ンターの比類なきスケーラビリティ との連携により、インフラストラクチャソリューションのポートフォリ

オに、NVIDIA DGX POD™の最高クラスのリファレンスアーキテクチャ

DGXシステムの中で最速のI/Oアーキテクチャを備 が加わりました。これらのソリューションは、NVIDIAパートナーネット

えたNVIDIA DGX A100は、NVIDIA DGX Super ワーク(NPN)を通じて、すぐに導入可能な完全統合型サービスとして提

POD™のような大規模なAIクラスターのための基本 供されるため、データセンターへの AI 導入を簡素化かつ迅速化できます。

NVIDIA DGX A100 の詳細については、www.nvidia.com/ja-jp/data-center/dgx-a100/をご覧ください。

© 2020 NVIDIA Corporation. All rights reserved. NVIDIA、NVIDIA のロゴ、NVIDIA DGX A100、NVLink、DGX SuperPOD、DGX POD、CUDA は、NVIDIA Corporation の商標または

登録商標です。すべての会社名および製品名は、関係各社の商標または登録商標です。機能、価格、提供状況、および仕様は予告なしに変更されることがあります。2020年11月