1/6ページ

ダウンロード(2.5Mb)

マイクロプロセッサにおける LLM の最適化手法

家電製品、産業用機器、自動車といった組込み機器は、コストと消費電力を所定の範囲内に収める必要があるため、コンピューティングリソースとメモリサイズの制約を受けます。また組込み機器は常にネットにつながっているわけではない場合もあります。このようなエッジ・デバイスに置いてLLM(大規模言語モデル:Large Language Model)を実現する手法をご紹介します。

このカタログについて

| ドキュメント名 | エッジに生成 AI を安全かつ効率的に展開 |

|---|---|

| ドキュメント種別 | ホワイトペーパー |

| ファイルサイズ | 2.5Mb |

| 登録カテゴリ | |

| 取り扱い企業 | NXPジャパン株式会社 (この企業の取り扱いカタログ一覧) |

この企業の関連カタログ

このカタログの内容

Page1

エッジに生成 AI を安全かつ効率的に展開:

マイクロプロセッサにおける LLM の最適化手法

NXP Semiconductors

概要

大規模言語モデル(Large Language Model:LLM)が社会に登場したことで、消費者向けおよび企業

向けテクノロジにおける人工知能(Artificial Intelligence:AI)機能の需要が大幅に高まりました。し

かし、生成 AI の普及に伴い、基盤モデルの抱える落とし穴も明らかになりました。「エッジへの基盤モ

デルの展開方法」と「プライベート・データに合わせたモデルのチューニング方法」が、生成 AI の発

展、および多様なデバイスやユース・ケースへの AI の適用を妨げる 2 つの大きな課題となっています。

基盤モデルには多大な計算能力とメモリが必要になるため、展開場所はデータ・センターやクラウド接

続環境に限られます。さらに、生成モデルは事実と異なる傾向が強く、情報をでっち上げたり、他の論

理的な誤りを起こしたりしがちです(「ハルシネーション」と呼ばれます)。そのため、AIシステムは生

成モデルの活用に課題を抱えています。計算の複雑性については、LLM 固有の最適化手法により軽減で

きます。また、ファイン・チューニングや検索拡張生成(Retrieval Augmented Generation:RAG)

などの手法により、学習時には利用できなかったプライベート・ソースやデータ、あるいは専門知識の

ソースやデータへアクセスさせることで、AI が生成する出力の正確性も改善できます。本論文では、生

成 AI の応用に関する 2 つの主要課題を解決する手法として、モデル最適化と RAG を用いて、電力効率

の高い組込みアプリケーション・プロセッサ上で LLM を実行する新しいパイプラインを導入します。こ

の手法により、プライバシー保護に配慮した AI ワークフローの開発や、AI エ ージェント、ヒューマノ

イド・ロボティクス、医療機器、産業機器、IoT、車載インフォテイメントの今後の発展に向けた、効率

的なパイプラインを構築できます。

はじめに

LLM と大規模マルチモーダル・モデル(Large Multi-Modal バーチャル・セールス、バーチャル BDR (Business

Model:LMM)が自然言語処理(Natural Language Development Representative)、コーディング・コパイ

Processing:NLP)などの AI 分野に活用されるようになっ ロット、会議の自動文字起こし、Q&A の作成、テキストの画

たことで、企業にも消費者にも新たな可能性が生まれまし 像変換などのアプリケーションが普及したことで、AI 機能は

た。こうしたモデルの多くはインターネット上のパブリッ 日常生活の一部となりつつあります。

ク・ソースで公開されている大量のデータセットでトレーニ 本論文の執筆時点では、こうしたユース・ケースの大多数の

ングされており、モデルを活用したアプリケーションは今や 基盤として、高帯域インターネットと高性能コンピューティ

世界中の多くの人に使われています。2022 年後半に、AI の ング(NVIDIA や AMD の GPU など)が用いられていま

研究と展開を進める企業である OpenAI から ChatGPT が発 す。一方、新しい基盤モデルがリリースされるたびに、以下

表されて以降、瞬く間に開発者サイトやクラウド・コン のように前世代からの大幅な発展も見られています。

ピュ ーティング・プラットフォームで多数のクローズドソー

ス・モデル API とオープンソース LLM ウェイトが公開され

るようになりました。メールの要約やコピーライティング、

Page2

• モデル・メモリの改善:より大きな入出力に対応するため 以下の図 2 に、高度なモデルであっても思いも寄らない間違

にコンテキスト長を拡大 いが起こり得る仕組みを示します。

• モデル推論の高速化:トークン生成の改善により応答速度

を向上

• モデル・サイズの縮小:モデル・パラメータ数の削減によ

りモデル容量を縮小

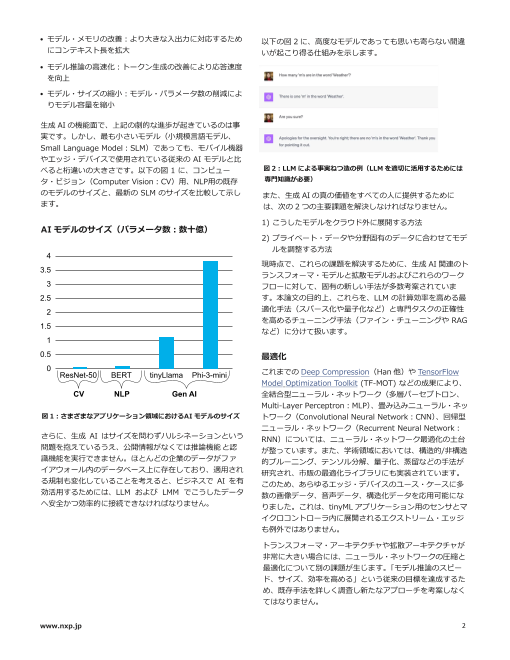

生成 AI の機能面で、上記の劇的な進歩が起きているのは事

実です。しかし、最も小さいモデル(小規模言語モデル、

Small Language Model︓SLM)であっても、モバイル機器

やエッジ・デバイスで使用されている従来の AI モデルと比

べると桁違いの大きさです。以下の図 1 に、コンピュー 図 2:LLM による事実ねつ造の例(LLM を適切に活用するためには

タ・ビジョン(Computer Vision︓CV)用、NLP用の既存 専門知識が必要)

のモデルのサイズと、最新の SLM のサイズを比較して示し また、生成 AI の真の価値をすべての人に提供するために

ます。 は、次の 2 つの主要課題を解決しなければなりません。

1) こうしたモデルをクラウド外に展開する方法

AI モデルのサイズ(パラメータ数︓数十億)

2) プライベート・データや分野固有のデータに合わせてモデ

ルを調整する方法

4

現時点で、これらの課題を解決するために、生成 AI 関連のト

3.5

ランスフォーマ・モデルと拡散モデルおよびこれらのワーク

3 フローに対して、固有の新しい手法が多数考案されていま

2.5 す。本論文の目的上、これらを、LLM の計算効率を高める最

2 適化手法(スパース化や量子化など)と専門タスクの正確性

を高めるチューニング手法(ファイン・チューニングや RAG

1.5 など)に分けて扱います。

1

0.5 最適化

0

ResNet-50 BERT tinyLlama Phi-3-mini これまでの Deep Compression(Han 他)や TensorFlow

Model Optimization Toolkit (TF-MOT) などの成果により、

CV NLP Gen AI 全結合型ニューラル・ネットワーク(多層パーセプトロン、

Multi-Layer Perceptron:MLP)、畳み込みニューラル・ネッ

図 1:さまざまなアプリケーション領域におけるAI モデルのサイズ トワーク(Convolutional Neural Network:CNN)、回帰型

ニューラル・ネットワーク(Recurrent Neural Network:

さらに、生成 AI はサイズを問わずハルシネーションという RNN)については、ニューラル・ネットワーク最適化の土台

問題を抱えているうえ、公開情報がなくては推論機能と認 が整っています。また、学術領域においては、構造的/非構造

識機能を実行できません。ほとんどの企業のデータがファ 的プルーニング、テンソル分解、量子化、蒸留などの手法が

イアウォール内のデータベース上に存在しており、適用され 研究され、市販の最適化ライブラリにも実装されています。

る規制も変化していることを考えると、ビジネスで AI を有 このため、あらゆるエッジ・デバイスのユース・ケースに多

効活用するためには、LLM および LMM でこうしたデータ 数の画像データ、音声データ、構造化データを応用可能にな

へ安全かつ効率的に接続できなければなりません。 りました。これは、tinyML アプリケーション用のセンサとマ

イクロコントローラ内に展開されるエクストリーム・エッジ

も例外ではありません。

トランスフォーマ・アーキテクチャや拡散アーキテクチャが

非常に大きい場合には、ニューラル・ネットワークの圧縮と

最適化について別の課題が生じます。「モデル推論のスピー

ド、サイズ、効率を高める」という従来の目標を達成するた

め、既存手法を詳しく調査し新たなアプローチを考案しなく

てはなりません。

www.nxp.jp 2

Page3

ワンショット量子化および混合精度を用いると、モデルを もう1つの方法は、LLMとプライベート・データを連携させ

1/4~1/32 に軽量化できるという単純明快なメリットがあ ることです。この場合、モデル・ウェイトの再トレーニン

グや更新は行いません。独自の知識ソースを利用してモデ

ります。FP32 精度を INT 8 精度に(1/4)、あるいは完全 ルの出力を調整する手法の例としてはRAGが挙げられます

2 値(1 ビット)のウェイトおよび活性化関数により最大で が、その実装方式はさまざまです。ファイン・チューニン

1/32 に削減できます。しかしながら、特に正確性の制約が グとは対照的に、RAGでは企業やユーザーが各自のデータ

ある場合や、再トレーニングのコストが大きい場合には、特 を非公開に保つことができ、またそれらのデータはLLMの

実行時以外には参照されません。以下の図3に、RAGのコン

定のニューラル・ネットワークを量子化することは単純な作 セプトと主なメリットを示します(参照︓2312.10997

業ではありません。こうした理由から、有望なLLM 最適化手 (arxiv.org))。

法として、効率的なトレーニング後量子化(Post-Training

Quantization:PTQ)の手法が考案されています(GPTQ な

ど)。

他の LLM 最適化手法としては、投機的デコーディング、蒸

留、低ランク分解、低レベルの最適化・推論エンジン

(Llama.cpp など)が挙げられます。

チューニング

多くの生成 AI ユース・ケースでは、最適化済みの軽量モデ

ルだけでなく、当初のモデル・トレーニングには含まれてい

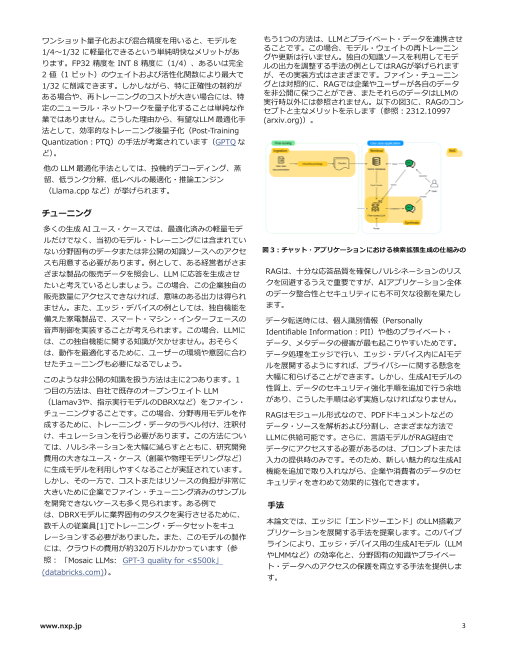

ない分野固有のデータまたは非公開の知識ソースへのアクセ 図 3:チャット・アプリケーションにおける検索拡張生成の仕組みの

スも用意する必要があります。例として、ある経営者がさま

ざまな製品の販売データを照会し、LLM に応答を生成させ RAGは、十分な応答品質を確保しハルシネーションのリス

たいと考えているとしましょう。この場合、この企業独自の クを回避するうえで重要ですが、AIアプリケーション全体

販売数量にアクセスできなければ、意味のある出力は得られ のデータ整合性とセキュリティにも不可欠な役割を果たし

ません。また、エッジ・デバイスの例としては、独自機能を ます。

備えた家電製品で、スマート・マシン・インターフェースの データ転送時には、個人識別情報(Personally

音声制御を実装することが考えられます。この場合、LLMに Identifiable Information︓PII)や他のプライベート・

は、この独自機能に関する知識が欠かせません。おそらく データ、メタデータの侵害が最も起こりやすいためです。

は、動作を最適化するために、ユーザーの環境や意図に合わ データ処理をエッジで行い、エッジ・デバイス内にAIモデ

せたチューニングも必要になるでしょう。 ルを展開するようにすれば、プライバシーに関する懸念を

このような非公開の知識を扱う方法は主に2つあります。1 大幅に和らげることができます。しかし、生成AIモデルの

つ目の方法は、自社で既存のオープンウェイト LLM 性質上、データのセキュリティ強化手順を追加で行う余地

(Llamav3や、指示実行モデルのDBRXなど)をファイン・ があり、こうした手順は必ず実施しなければなりません。

チューニングすることです。この場合、分野専用モデルを作 RAGはモジュール形式なので、PDFドキュメントなどの

成するために、トレーニング・データのラベル付け、注釈付 データ・ソースを解析および分割し、さまざまな方法で

け、キュレーションを行う必要があります。この方法につい LLMに供給可能です。さらに、言語モデルがRAG経由で

ては、ハルシネーションを大幅に減らすとともに、研究開発 データにアクセスする必要があるのは、プロンプトまたは

費用の大きなユース・ケース(創薬や物理モデリングなど) 入力の提供時のみです。そのため、新しい魅力的な生成AI

に生成モデルを利用しやすくなることが実証されています。 機能を追加で取り入れながら、企業や消費者のデータのセ

しかし、その一方で、コストまたはリソースの負担が非常に キュリティをきわめて効果的に強化できます。

大きいために企業でファイン・チューニング済みのサンプル

を開発できないケースも多く見られます。ある例で 手法

は、DBRXモデルに業界固有のタスクを実行させるために、

数千人の従業員[1]でトレーニング・データセットをキュ 本論文では、エッジに「エンドツーエンド」のLLM搭載ア

レーションする必要がありました。また、このモデルの製作 プリケーションを展開する手法を提案します。このパイプ

には、クラウドの費用が約320万ドルかかっています(参 ラインにより、エッジ・デバイス用の生成AIモデル(LLM

照︓ やLMMなど)の効率化と、分野固有の知識やプライベー

「Mosaic LLMs: GPT-3 quality for <$500k」

ト・データへのアクセスの保護を両立する手法を提供しま

(databricks.com))。 す。

www.nxp.jp 3

Page4

Float32 SmoothQuant SmoothQuant

(CPU) INT8 (CPU) INT8 (NPU)

TTFT 9.61 3.1 1.417

(秒)

図 4:RAG を搭載した eIQ GenAI Flow

TPS 2.12 4.25 4.76

多くのAIユース・ケースでは、ユーザーに価値を提供する (トークン数)

ため、プロンプトと出力を複数用意しなければなりませ

ん。つまり、センサ、データ、および全体的なシステム設 表 1:i.MX 95 アプリケーション・プロセッサでの量子化前後におけ

計を包括的に把握できるようにする必要があります。私た る tinyLlama-1B の推論性能(トークン 143 個の入力シーケンス)

ちのパイプラインでは、音声コマンドを用いて応答と情報

の取得をインテリジェントに行うヒューマン・マシン・イ LLM のチューニング

ンターフェース用オーディオ・タスクを、複数のモジュー 本パイプラインでは、最適化済みモデルだけでなく、LLM で

ルで実装します。 生成される出力のカスタマイズも可能です。本論文では、

LLM にプライベート・データを安全かつ効率的に提供するた

直近のeIQ® GenAI Flowの発表で紹介したように、このモ

めに、自社開発の RAG 手法を使用しています。

デルでは他のAIモデルへの入力と出力の両方を受け取りま

す。さらに、パイプラインでは、LLMと接続する効率的な はじめにで述べたように、アプリケーション全体の整合性と

RAGモジュールも提供します。実装を実現可能なものとす セキュリティを確保するうえで、この点は重要です。分野専

るためには、まずモデルをターゲット・デバイスに対して 用モデルの事前トレーニングまたはファイン・チューニング

最適化する必要があります。 を行えば、言語モデルに供給するデータを顧客が制御できま

すが、トレーニング、開発、保守にかかるコストが増大しま

LLM の展開 す。このコストは、LLM または LMM のサイズだけでなく、

データ・ソースのサイズにも比例します。

LLM の推論機能と自動化機能を十分に活用するには、まず

機能面の性能を満たすように推論を高速化するモデルの実行 代案として、本パイプラインではきわめて小さな組込みモデ

フレームワークを提供する必要があります。 ルを使用しています。RAG を採用したことで、プライベー

ト・データで LLM の応答を「カスタマイズ」できるだけで

量子化 なく、一般的な AI モデル(GPT など)にこの非公開の知識

本論文では、LLM を最適化するため、TinyLlamaONNX 1B ソ ースを公開せず、組込みデバイス環境内に留められると

を使用し、SmoothQuantINT8 量子化[2]を適用しました。 いう追加のメリットも得られました。

ノードの種類を変えた 2 種の量子化済みモデルを試したと

ころ、2 番目のバージョンの方が高い性能を発揮しました。

NXP i.MX95 アプリケーション・プロセッサ評価ボードで

のテストの結果、推論のスループットについては 2 番目の

バージョンの量子化済みモデルの方が優れていました。

INT8 の有効性を踏まえ、現在はスループットおよびパイプ

ライン全体の性能を高めるため、Gemma-2B などのモデル

やDanube0.5B などの SLM のテストを進めています。

高速化

本パイプラインでは、LLM の量子化に加え、i.MX95

Neutron NPU コアによる高速化も行っています。モデルの 図 5:車載ユース・ケースにおける RAG ファイン・チューニングを

高速化のため、今回は TinyLlama-1B 量子化済みモデルに 使用した応答の例

ついて、ONNXRT 実行プロバイダから NXP の Neutron 実

行プロバイダへとモデルの連携を行いました。

TTFT(Time to First Token)と TPS(Tokens per Second)

により、システムの性能を計測しています。TTFT はプロン

プト/クエリが入力されてから最初のトークンが生成される

までの時間を表し、TPS は推論のスループットを表しま

す。

www.nxp.jp 4

Page5

NXP が開発した RAG 手法では、効率化のため次のサブス この例を踏まえると、モバイル・ロボティクスも、機械に生成

テップを組み込んでいます。 モデルを組み込んで一定の認識力と推論力を与えることで、人

間らしさを加えて普及を後押しできる領域と言えます。例え

• ドキュメントの前処理

ば、人間のオペレータがヒューマノイド・ロボット向けの設計

• チャンク化(LLM の応答で使用できるテキストのチャンク 図や作業リストを提示する場合に、ロボットにOCRとRAGを

を作成する) 組み込み、人間から提示されたコンテキストに合わせて調整し

• 埋め込み(テキストをトークンで表現する) た音声をLLMで生成するケースが考えられます。

• 検索のハイパーパラメータ GenAI FlowとRAGの組み合わせにより、Q&Aの作成、AI主導

型のカスタマー・サービス、ファクトリ・オートメーションな

例えば、新型自動車のサービス・マニュアルをテキスト・ どのさまざまなユース・ケースをエッジで実現できます。ご興

データのソースとして利用できます。追加のRAGプロンプト 味をお持ちの方は、NXPの営業担当者にお問い合わせくださ

のサイズはきわめて小さいため、LLM推論のスピードを維持 い。ご自身のサンプル・データ(ドキュメントなど)

したまま、車載UIが人間からの問いかけに対して一般的な会 で、FlowとRAGの組み合わせの効果をお試しいただけます。

話とほぼ同じ速さで回答できるようになります。

本論文では、LLMの展開方法とチューニング方法という主要課

エンドツーエンドAI 題を解決し、エッジ製品やサービスで最新世代の生成AIのメ

リットを十分に活用する手法を示しました。

本LLMパイプラインの入出力は、他のAIモジュールに依存し

ます。今回は、ウェイク・ワード(Wake Words︓WW)、自

動音声認識(Automatic Speech Recognition︓ASR)、テ

キスト読み上げ(Text-to-Speech︓TTS)を使用しました。

LLM - パラメータ数 NXP アプリケーション・プロセッ

ウェイク・ワード (WW) サ

本パイプラインに搭載される軽量モジュールであり、複雑な TinyLlama-1.1B i.MX 95、i.MX 93、i.MX 8M Plus

分析のトリガを担当します。定評のあるキーワード検出ユー Gemma-2B i.MX 95

ス・ケースを基に構築されています。

Llamav2-7B i.MX 95

自動音声認識 (ASR)︓本パイプラインの1ステップであり、

ユーザーからの自然言語によるクエリをOpenAIのWhisper Danube-0.5B i.MX 95

モデルで記録します。 表 2:テスト対象の LLM と対応 NXP 製品

テキスト読み上げ (TTS)︓本パイプラインの最終出力であ

り、AIで生成された音声が含まれます。 本パイプラインで

は、このように高度な機能(LLMなど)もプロセッサ上で

ローカルに実行されるので、トークンの生成速度を最大限に

高め、ユーザーに対してインターフェースの優れた応答性を

確保できます。

eIQ GenAI Flow︓すべての要素を統合

複数のモデルを連結させ、LLM量子化、高速化、RAGも組み

合わせることで、非常に複雑なAIタスクに対しても、エッ

ジ・デバイス単体で過去に例のない性能を実現できます。

さまざまな業界や垂直市場で生成AIの利用が進んでいること

を受け、GenAI Flowのニーズは広がっています。例えば、

医療機器では、感染のリスクの観点から、医師、患者、他の

機械との接触を最小限に抑える必要があります。LLMとRAG

を利用し、医療分野固有のデータを理解できる音声AIイン

ターフェースは、ヘルスケアでのGen AIの有効な活用法の1

つです。

www.nxp.jp 5

Page6

お問い合わせ先

ホーム・ページ: www.nxp.com

Web サポート:www.nxp.com/support

米国/ヨーロッパ/記載されていないそれ以外の地域:

NXP Semiconductors USA, Inc.

Technical Information Center, EL516

2100 East Elliot Road

Tempe, Arizona 85284

+1-800-521-6274 または+1-480-768-2130

www.nxp.com/support

ヨーロッパ/中東/アフリカ:

NXP Semiconductors Germany GmbH

Technical Information Center

Schatzbogen 7

81829 Muenchen, Germany

+44 1296 380 456(英語)

+46 8 52200080(英語)

+49 89 92103 559(ドイツ語)

+33 1 69 35 48 48(フランス語)

www.nxp.com/support

日本:

NXP ジャパン

〒150-6024 東京都渋谷区恵比寿 4-20-3

恵比寿ガーデンプレイスタワー 24F

0120 950 032(国内通話無料)

www.nxp.com/jp/support/

アジア/太平洋地域:

NXP Semiconductors Hong Kong Ltd.

Technical Information Center

2 Dai King Street

Tai Po Industrial Estate

Tai Po, N.T., Hong Kong

+800 2666 8080

support.asia@nxp.com

参照資料

[1] Dolly: Open Instruction-Tuned LLM | Databricks ブログ

[2] Xiao, G., Lin, J., Seznec, M., Wu, H., Demouth, J., & Han, S.(2023 年 7 月)。「Smoothquant: Accurate and

efficient post-training quantization for large language models」(International Conference on Machine Learning)

(38087~38099 ページ)。PMLR

詳細情報:nxp.jp

NXP および NXP のロゴは、NXP B.V.の商標です。その他すべての製品名、サービス名は、それぞれの所有者に帰属します。© 2024 NXP B.V.

ドキュメント番号: AIRAGWP REV 0