1/5ページ

ダウンロード(1.4Mb)

AI開発を効率的に進めるための、オリジナルGPUサーバーパッケージをご紹介

AIモデルの作成に必要なものとして、モデル(アルゴリズム)や学習データが重要であることは一般的に知られていますが、実はAIプラットフォーム(インフラ基盤)も同じくらい重要な要素となります。AIプラットフォームとは、学習データの収集・処理、アプリケーションを動作させる基盤などを提供するものを指し、代表的な例としてGPUサーバーが挙げられます。しかし、「データ処理・計算の大きさとGPUのスペックが合わない」「費用対効果が見えない」などの課題もあり、単に高性能なAI基盤を導入・構築し、活用することで必ず成果が表れる、スピーディな商用化を実現できるとは限りません。

したがって、GPUの効果を最大限発揮するためには、お客様の用途に合わせた最適なAIプラットフォーム選定が必要です。

東京エレクトロンデバイスでは、AIプラットフォームに最適な製品を選定いただくためのGPUサーバーパッ

ケージや導入支援サービスをご用意し、お客様のAI開発をプラットフォームの観点から支援いたします。

このカタログについて

| ドキュメント名 | 東京エレクトロンデバイス オリジナル GPU サーバーパッケージ |

|---|---|

| ドキュメント種別 | 製品カタログ |

| ファイルサイズ | 1.4Mb |

| 登録カテゴリ | |

| 取り扱い企業 | 東京エレクトロンデバイス株式会社 (この企業の取り扱いカタログ一覧) |

この企業の関連カタログ

このカタログの内容

Page1

最適なGPUサーバーでAI開発を効率的に!

東京エレクトロンデバイスのオリジナルGPUサーバーパッケージ

気軽に触れる1台目のGPUサーバーが欲しい

販売終了モデルDGX StationA100と同スペックのサーバーを用意したい

最新GPU H100搭載サーバーで開発環境を作りたい

お客様の課題感に合わせたGPUパッケージを提供

Page2

最適なGPUサーバーでAI開発を効率的に!

東京エレクトロンデバイスのオリジナルGPUサーバーパッケージ

近年、AIを搭載したシステムやサービスを目にすることが多くなり、業界・業種問わずAIの商用利用が急

速に進んでいます。「AI」という言葉自体は目新しい言葉ではありませんが、昨今急激に発展している背景

には、AIの開発基盤となるAIプラットフォームの進化も1つの要因として考えられています。

AIモデルの作成に必要なものとして、モデル(アルゴリズム)や学習データが重要であることは一般的に知

られていますが、実はAIプラットフォーム(インフラ基盤)も同じくらい重要な要素となります。

AIプラットフォームとは、学習データの収集・処理、アプリケーションを動作させる基盤などを提供するも

のを指し、代表的な例としてGPUサーバーが挙げられます。しかし、「データ処理・計算の大きさとGPUの

スペックが合わない」「費用対効果が見えない」などの課題もあり、単に高性能なAI基盤を導入・構築し、

活用することで必ず成果が表れる、スピーディな商用化を実現できるとは限りません。

したがって、GPUの効果を最大限発揮するためには、お客様の用途に合わせた最適なAIプラットフォーム選

定が必要です。

東京エレクトロンデバイスでは、AIプラットフォームに最適な製品を選定いただくためのGPUサーバーパッ

ケージや導入支援サービスをご用意し、お客様のAI開発をプラットフォームの観点から支援いたします。

導入への課題

気軽に触れる1台目のGPUサーバーが欲しい

販売終了モデルDGX StationA100と同スペックのサーバーを用意したい

最新GPU H100搭載サーバーで開発環境を作りたい

東京エレクトロンデバイスでは、お客様の課題感に合わせたGPUパッケージを提供しています。

エンタープライズ向け 高性能画像処理 DGX Station A100 最新世代H100搭載 GPUワークステーション

GPUお試しパッケージ ワークステーション リプレース検討モデル GPUサーバー 水冷モデル

最新アーキテクチャ採用製品をご提案 お客様構成での事前検証 組み立て時全台検査を実施

最新CPUやNVMe/GPUなどの最新 お見積3り0構21成6はP事6前SにP弊R社-のAラ9ボ8環W境RBパーツ組み立て完了後に全台動作確認

アーキテクチャに対応した充実のライ にて検証を行い動作確認を行った上で を行う事で着荷時の初期不良を最小限

ンナップを提供しています。 ご提案します。 に抑えます。

本資料では、東京エレクトロンデバイスオリジナルの

GPUサーバーパッケージをご紹介します

Page3

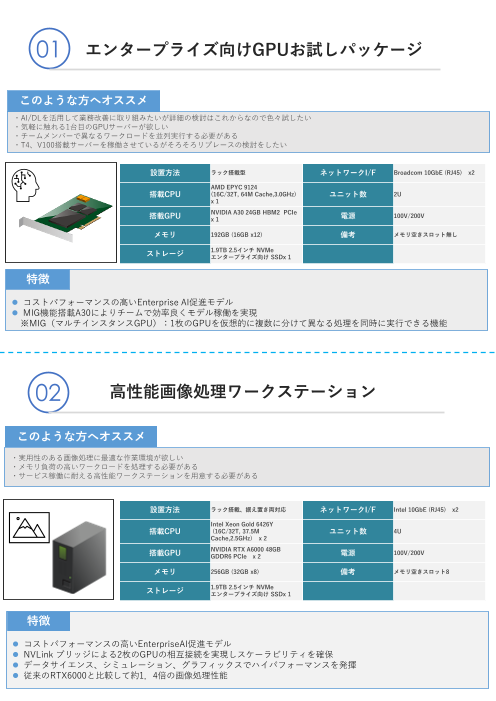

01 エンタープライズ向けGPUお試しパッケージ

このような方へオススメ

・AI/DLを活用して業務改善に取り組みたいが詳細の検討はこれからなので色々試したい

・気軽に触れる1台目のGPUサーバーが欲しい

・チームメンバーで異なるワークロードを並列実行する必要がある

・T4、V100搭載サーバーを稼働させているがそろそろリプレースの検討をしたい

設置方法 ラック搭載型 ネットワークI/F Broadcom 10GbE (RJ45) x2

AMD EPYC 9124

搭載CPU (16C/32T, 64M Cache,3.0GHz) ユニット数 2U

x 1

NVIDIA A30 24GB HBM2 PCIe

搭載GPU x 1 電源 100V/200V

メモリ 192GB (16GB x12) 備考 メモリ空きスロット無し

1.9TB 2.5インチ NVMe

ストレージ

エンタープライズ向け SSDx 1

特徴

⚫ コストパフォーマンスの高いEnterprise AI促進モデル

⚫ MIG機能搭載A30によりチームで効率良くモデル稼働を実現

※MIG(マルチインスタンスGPU):1枚のGPUを仮想的に複数に分けて異なる処理を同時に実行できる機能

02 高性能画像処理ワークステーション

このような方へオススメ

・実用性のある画像処理に最適な作業環境が欲しい

・メモリ負荷の高いワークロードを処理する必要がある

・サービス稼働に耐える高性能ワークステーションを用意する必要がある

設置方法 ラック搭載、据え置き両対応 ネットワークI/F Intel 10GbE (RJ45) x2

Intel Xeon Gold 6426Y

搭載CPU (16C/32T, 37.5M ユニット数 4U

Cache,2.5GHz) x 2

NVIDIA RTX A6000 48GB

搭載GPU GDDR6 PCIe x 2 電源 100V/200V

メモリ 256GB (32GB x8) 備考 メモリ空きスロット8

1.9TB 2.5インチ NVMe

ストレージ

エンタープライズ向け SSDx 1

特徴

⚫ コストパフォーマンスの高いEnterpriseAI促進モデル

⚫ NVLink ブリッジによる2枚のGPUの相互接続を実現しスケーラビリティを確保

⚫ データサイエンス、シミュレーション、グラフィックスでハイパフォーマンスを発揮

⚫ 従来のRTX6000と比較して約1.4倍の画像処理性能

Page4

03 DGX Station A100リプレース検討モデル

このような方へオススメ

・既に商用環境でDGX StationA100を使用しているが同等スペックでリプレースできる筐体を用意する必要がある

・最新DGXラインナップだとハイレンジ過ぎて現状サービス規模に合わない

・純正DGX StationA100のサポートレベルだと運用面で煩雑

設置方法 ラック搭載、据え置き両対応 ネットワークI/F Intel 10GbE (RJ45) x2

Intel Xeon Gold 6454S

搭載CPU (32C/64T, 60M Cache, 2.2GHz) ユニット数 4U

x 2

NVIDIA A100 80GB CoWoS

搭載GPU HBM2 PCIe x 4 電源 200V

メモリ空きスロット無し

メモリ 512GB (32GB x16) 備考 NV Link機能をご検討の場合は

別途、ご相談ください。

1.9TB 2.5インチ NVMe

ストレージ 7.68TB 2.5インチ NVMe

エンタープライズ向け SSDx各 1

特徴

⚫ 販売終了モデルDGX StationA100と同等のスペックを再現

⚫ 安心のH/Wサポートも併せてご提供

04 最新世代H100搭載GPUサーバ

このような方へオススメ

・NVIDIA最新世代 H100GPUの性能を評価したい

・最新DGXラインナップだとハイレンジ過ぎて現状サービス規模に合わない

設置方法 ラック搭載、据え置き両対応 ネットワークI/F Intel 10GbE (RJ45) x2

Intel Xeon Gold 6426Y

(16C/32T, 37.5M Cache,

搭載CPU ユニット数 4U

2.5GHz)

x 2

NVIDIA H100 80GB HBM2e

搭載GPU PCIe 電源 100V/200V

x 1

メモリ空きスロット8

メモリ 256GB (32GB x8) 備考

GPUを追加する場合200V環境必須

1.9TB 2.5インチ NVMe

ストレージ

エンタープライズ向け SSDx 1

特徴

⚫ NVIDIA最新世代H100を搭載

⚫ 大規模化するデータセット環境下でも高速な分析を実現

⚫ 注目のChatGPTを始めとする言語解析分野で高パフォーマンスを提供

Page5

05 GPUワークステーション水冷モデル

このような方へオススメ

・設置環境にラックが無いが高性能GPUインフラが欲しい

・オフィスに置いてある既存製品のファンがうるさい

設置方法 ラック搭載型 ネットワークI/F Intel 10GbE (RJ45) x2

AMD EPYC 9124

搭載CPU (16C/32T, 64M Cache,3.0GHz) ユニット数 5U

x 1

NVIDIA A100 80GB HBM2e PCle

Liquid cooling x4

搭載GPU ※NVLINK For Ampere 2Slot 電源 200V

Retail x6

メモリ空きスロット無し

メモリ 512GB (32GB x16) 備考 OS、キーボード・マウスディスプ

レイは付属しておりません

1.9TB 2.5インチ NVMe

エンタープライズ向け SSDx 1

ストレージ

7.68TB2.5インチNVMeエンター

プライズ向けSSDX1

特徴

⚫ 置き場所を選ばない静音性と高性能を兼ね備えたAIプラットフォーム

⚫ 最大4 枚の水冷 A100 GPU カードをサポート

⚫ 専用設備不要で空冷サーバと変わらないメンテナンス性

東京エレクトロンデバイスの提供するサービス

導入時の現地作業 GPU搭載サーバーの貸出し

⚫ 現地でのサーバー導入作業 ⚫ NVIDIA A30、A100搭載サーバーの貸出し

⚫ システム一式の導入作業の請負 ⚫ AI開発環境セットアップ支援オプション

性能検証・サイジング ハンズオン・座学トレーニング

⚫ 弊社Lab環境での性能検証 ⚫ NGCを活用したハンズオントレーニング

⚫ 検証結果に基づいた適切な製品選定 ⚫ AIの基礎を理解する座学コース

~AI基盤の導入に関して、まずはお気軽にご相談ください~

※製品によっては、現在納期が長期化しております。納期の最新情報についてはお問い合わせください。

本紙に記載された会社名、ロゴ、ブランド名、製品名、サービス名は各社の商標または登録商標です。

その他全ての商標および登録商標はそれぞれの所有者に帰属します。

CN BU https://cn.teldevice.co.jp

新宿:〒163-1034 名古屋:〒451-0045

東京都新宿区西新宿3-7-1 新宿パークタワー S34階 愛知県名古屋市西区名駅2-27-8 名古屋プライムセントラルタワー8階

Tel.03-5908-1990 Fax.03-5908-1991 Tel.052-562-0826 Fax. 052-561-5382

大阪:〒540-6033 つくば:〒305-0033

大阪府大阪市中央区城見1-2-27 クリスタルタワー33階 茨城県つくば市東新井15-4 関友つくばビル7階

Tel.06-4792-1908 Fax.06-6945-8581 Tel.029-848-6030 Fax.029-848-6035

お問い合わせは、Webサイトの右記フォームよりお願いします。 https://cn.teldevice.co.jp/product/****/form.html